연중 기획 [AX 인사이트]

삼성증권 리서치센터 류형근 선임연구원 인터뷰

인공지능 중심 'GPU' 개발한 엔비디아 주가 급등

엔비디아 신제품 주기 짧고 AI 상용화 지연 변수

고대역폭메모리(HBM) 생산↑…AI 온기 확산 예상

2022년 말 오픈AI의 챗GPT(3.5) 출시가 주식시장에서 '인공지능(AI) 테마주 열풍'으로 이어진 지 일년 반 가량이 지났다. 최근 엔비디아를 중심으로 주가 변동성이 커지면서 AI 테마주에 대한 기대감과 우려가 상존하는 가운데 향후 AI 테마주의 향방에 투자자들의 관심이 쏠린다.

삼성증권 리서치센터에서 반도체 소부장(소재·부품·장비) 섹터를 담당하는 류형근 선임연구원은 "AI 주식 열풍, 언제까지 이어질 수 있겠느냐"는 질문에 "알 수 없다"고, 멋쩍은 웃음을 지으며 말했다.

그는 다만 "엔비디아의 짧은 신제품 발표 주기로 자체 수요 잠식 영향이 있다는 점과 실질적인 상용화까지 시간이 걸린다는 점은 우려 사항"이라면서도 "고대역폭메모리(HBM) 수요 급증에 따라 AI 반도체 산업의 온기는 확산할 것"이라고 내다봤다. 변동성 커졌지만 투자강도 거세진 엔비디아

류 연구원은 지난 7일 오전 삼성증권 본사에서 가진 인터뷰를 통해 "챗GPT가 처음 나왔을 때는 단순히 우리가 가지고 놀 수 있는 장난감이 생겼을 뿐, 실생활에 영향을 주지 못할 것이라는 인식이 있었다"면서도 "그러나 챗GPT(3.5)를 통해 돈을 벌 수 있다는 사실이 작년부터 확인됐다"고 말했다.

AI 열풍의 가장 큰 수혜주는 단연 엔비디아다. 엔비디아는 그래픽처리장치(GPU)를 처음 만들었다. 순차적으로 데이터를 처리하는 중앙처리장치(CPU)와 달리 GPU는 대규모 데이터를 동시에 처리할 수 있다. 빠른 연산이 필요한 AI 시장에서 GPU가 주목받은 이유다.

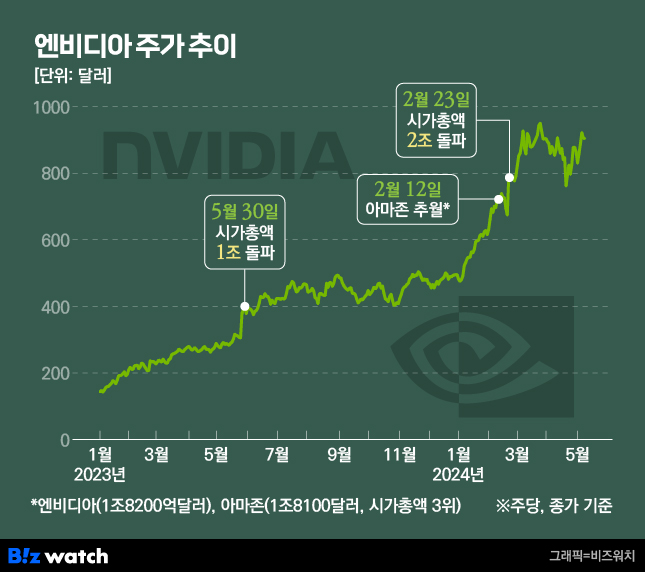

주가도 치솟았다. 지난해 1월 3일 엔비디아의 주가는 주당 143.15달러에서 지난 8일 904.12달러까지 500% 이상 올랐다. 2023년 5월 시가총액 1조 달러를 돌파했고, 올해 2월에는 시총 2조 달러를 돌파하고 글로벌 시가총액 3위였던 아마존(2월 12일 기준 1조 8100달러)을 제쳤다.

그러나 엔비디아의 단기 주가 변동성이 커지면서 '버블 논란'도 잇따르고 있다. 이에 대해 류 연구원은 "버블인지 여부는 결과적으로 사후에 판단할 수 있는 부분"이라면서도 "엔비디아 주가의 변동성은 커졌지만 결론적으로 연초 대비 주가가 상승하고 투자의 강도도 거세지고 있다"고 진단했다.

"엔비디아의 경쟁자는 엔비디아"

류 연구원은 AI 테마주 열풍에 대해 몇 가지 우려 사항을 짚었다. 첫번째는 AI 주식 열풍을 선도하고 있는 엔비디아의 경쟁자는 엔비디아 자신이라는 점이다. 엔비디아의 신제품 주기가 짧아지면서 자사 제품의 수요를 잠식할 수 있다는 우려다.

류 연구원은 "엔비디아의 현재 주력 GPU는 'H100(Hopper 100)'인데 최근 H100 칩 성능을 뛰어넘는 'B200(Blackwell 200)' 등 블랙웰 컴퓨팅을 선보였다"며 "하반기에 새로운 AI 칩 신제품을 또 선보일 예정"이라고 말했다.

B200에 집적된 트랜지스터는 모두 2080억개로 전작인 'H100(800억개)'의 두 배가 넘는다. 트랜지스터는 반도체 내에서 전류와 전압 흐름 등을 조절해 증폭하는 역할을 한다. 트랜지스터가 많을수록 더욱 빠르게 데이터를 처리할 수 있다.

류 연구원은 엔비디아의 신제품 발표 주기가 짧아지면서 당사의 제품에 대한 수요가 잠식할 수 있다고 우려했다. 그는 "기업이 신제품을 기다리면서 기존 제품의 주문 시기를 늦추는 등 수요의 이연 과정에 있다"고 분석했다.

두 번째는 AI를 활용해 실제 수익을 확보하기까지의 투자 대비 회수 시간이 길다는 점이다.

그는 "AI 나온 지 일 년 반 정도 지났는데 돈 벌 수 있는 아이디어가 명확해지지 않고 있다"며 "궁극적으로 AI를 통해 얻을 수 있는 서비스인 원격의료, 자율주행 등 까지의 비용 회수 기간이 너무 길다"고 지적했다.

가령 유료 챗GPT, 기업의 업무 자동화, GPT 스토어, 개인별로 원하는 대로 맞춤화할 수 있는 GPT 등은 비교적 짧은 시간에 활용할 수 있다. 그러나 자율주행, 원격의료 등은 법규 개정 등과 함께 가야 하는 부분이 있어 조금 더 먼 미래일 것으로 예상했다.

"온기의 확산은 HBM으로부터"

그럼에도 류 연구원은 당분간 반도체 생태계가 꾸준히 확대할 것으로 전망했다. AI 수요가 늘어가면서 삼성전자·SK하이닉스 등 반도체 업계가 빛을 보고 있는 가운데 삼성전자와 SK하이닉스에 부품을 납품하는 업체로도I 온기가 확산할 것이라는 전망이다.

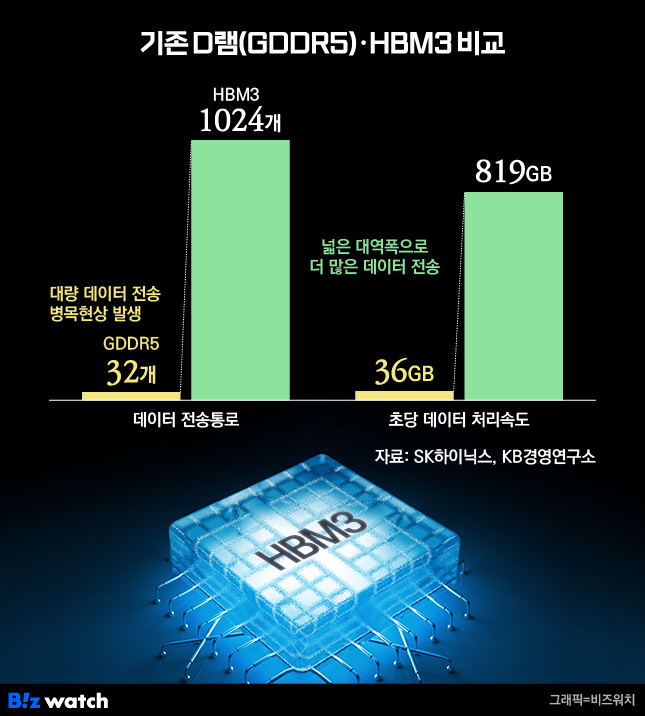

AI 업체 온기의 확산은 '고대역폭메모리(HBM)'로부터 시작될 것으로 보인다. KB경영연구소의 보고서에 따르면 기존 컴퓨터에서는 CPU와 메모리(D램) 사이의 연결 통로(BUS)를 통해 데이터가 이동한다. CPU 성능이 아무리 좋아도 인공지능과 같이 처리해야 할 데이터양이 증가하면 병목현상이 발생할 수밖에 없는 구조다.

데이터 이동 병목현상을 해소하기 위해 데이터 전송 능력을 높인 고대역폭메모리(HBM)가 국내 기업을 중심으로 출시되면서 주목을 받고 있다. 기존 D램인 GDDR5와 HBM3를 비교하면 HBM의 능력치가 명확해진다. 데이터 전송 통로와 데이터 처리 속도가 크게 향상됐다. HBM3의 전송속도인 '초당 819기가바이트(GB)'는 1초에 풀HD(FHD) 영화 163편을 전송할 수 있는 수준이다.

특히 지난 2013년 세계 최초로 HBM을 개발한 SK하이닉스는 글로벌 HBM 시장에서 점유율 70%가 넘는다.

다만 HBM의 단점으로는 △높은 공정 난이도 △낮은 수율 △기존 D램 대비 높은 제조 비용 등이 꼽힌다. 즉 같은 메모리 생산가능용량의 공정 하에서 생산할 때 기존 D램보다 HBM 생산량이 적다는 의미다. 메모리 생산 공정 확충이 필요한 이유다.

류 연구원은 "D램 생산가능용량 중 HBM 생산 비중이 확대하면서 사실상 D램 생산가능용량의 잠식 효과가 나타나고 있다"며 "D램 생산가능용량 중 내 HBM의 비중은 2023년 말 8%에서 2024년 말 21%로 증가할 것으로 예상됨에 따라 D램 전공정 투자 재개가 먼저 이뤄질 것"이라고 말했다.