AI(인공지능)의 발전은 반도체 시장에 많은 변화를 불러왔다. 반도체집적회로의 성능이 24개월마다 2배로 증가한다는 '무어의 법칙'은 AI 반도체 시장에서는 더 이상 통하지 않는 분위기다. 누군가는 외면했던 값비싼 HBM(고대역폭메모리)은 이례적으로 시장의 대세가 됐다. 이에 반도체 업계에서는 '넥스트 HBM' 기술을 선점하기 위한 움직임이 한창이다. 차세대 기술을 우선 확보해 예측하기 어려운 AI 시장에 빠르게 대응하고, 수위를 차지하기 위한 노력이다. HBM 열풍을 이을 미래 대세 기술을 앞서 살펴본다.[편집자]

AI는 더 빨라야 한다

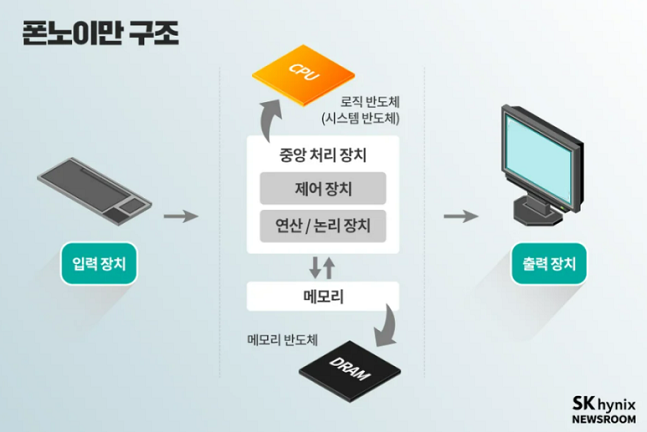

컴퓨터 역사에서 빠질 수 없는 인물이 있다. 범용 컴퓨터의 구조를 만든 '존 폰 노이만(John von Neumann)'이다. 인류 최초의 컴퓨터 '애니악'의 성능은 현재 전자계산기와 비교해도 낮은 수준이었다. 애니악은 현대 컴퓨터와 달리 다양한 프로그램을 수행할 수 있는 범용 컴퓨터가 아니었다. 다른 작업을 하기 위해서는 소자를 연결하고 있는 전선을 다시 배열해 논리 회로의 구성을 바꿔야 했다.

이에 폰 노이만은 초기 범용 컴퓨터 개발에 참여해 '폰 노이만 구조'를 제안했다. 이는 시스템을 통제하고 프로그램을 실행하는 CPU(중앙처리장치)와 처리된 정보를 저장하는 메모리가 분리된 구조다. CPU와 메모리가 분리돼 있기 때문에 CPU가 정보를 처리하고 연산하기 위해서는 메모리에 저장된 프로그램을 불러와 실행해야 한다.

다르게 말하면 메모리에 저장된 프로그램만 바꾸면 하드웨어 변경 없이도 다른 작업을 할 수 있다는 뜻이다. 하드웨어는 그대로 두고 기억장치에 있는 소프트웨어만 바꿔 작업을 처리하는 방식이다. 이는 현재 컴퓨터뿐만 아니라 스마트폰을 비롯한 여러 전자 기기 등의 근간이 되고 있다.

반도체 산업은 이러한 폰 노이만 구조에 따라 발전해 왔다. CPU 기업은 제어와 연산 성능을 향상시켜 속도를 높였고, 메모리 기업은 더 많은 정보를 담는 제품을 만들어 냈다.

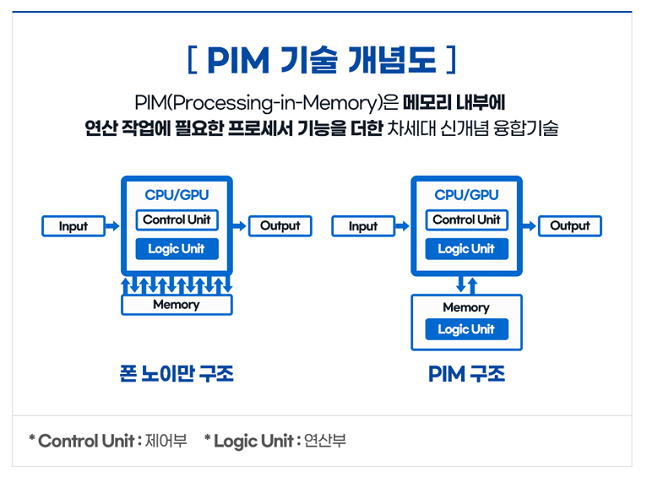

하지만 AI 등장으로 상황이 바뀌었다. 폰 노이만 구조는 한정된 데이터를 빠른 속도로 처리하는데 적합한 방식이다. 막대한 데이터를 스스로 처리하고 알아서 판단하는 AI에 적용하기에는 적절하지 않다. '폰 노이만 병목현상' 탓이다.

폰 노이만 구조에서는 CPU와 메모리 사이 하나의 통로로 데이터가 순차 이동하며 처리되는데, 데이터가 많아지면 지연 현상이 생긴다. 처리해야 할 데이터가 CPU에 도달하지 못해 컴퓨팅 장치가 대기하는 상황이 발생한다. 이것이 폰 노이만 병목현상이다.

이 병목현상 때문에 폰 노이만 구조에서 고성능·고효율의 AI 시스템을 구축하기엔 한계가 있다는 지적이 이어졌다. 일반적으로 AI 응용은 이미지 분류, 음성 인식, 기계 번역 분야에서 많이 활용된다. AI 시스템의 성능과 에너지 효율을 끌어올리기 위해 메모리의 성능 향상이 요구되는 이유다.

이에 반도체 업계에서는 데이터 이동 정체 문제를 풀기 위해 여러 연구를 지속하고 있다. 메모리 내부에서 일부 연산과 병렬처리가 가능한 'PIM(Processing-in-Memory)' 구조도 그중 하나다.

메모리의 새로운 패러다임

PIM은 저장 기능만 있던 메모리에 연산 작업에 필요한 프로세서 기능을 더한 '지능형 메모리 반도체'다. CPU가 메모리에서 데이터를 불러와 연산하는 폰 노이만 구조와 달리 메모리 내부에서 연산하는 것이 특징이다.

PIM은 메모리 반도체 내부 저장 공간(뱅크, Bank)마다 데이터를 처리하는 장치를 장착한다. 전용 내부 데이터 경로의 대역폭을 활용하기 때문에 데이터의 병렬처리가 가능해져 연산 속도가 빨라진다. 또 연산을 마친 소량의 데이터만 CPU·GPU로 전달해 병목 현상과 데이터 이동 거리를 획기적으로 줄인다. 전력 소모량을 절감하는 효과도 있다.

특히 PIM은 AI 연산 중 추론 영역에 특화된 제품이다. AI 반도체는 기능에 따라 크게 추론과 학습 두 가지 전문 분야로 구분할 수 있다. 추론은 데이터를 지연 시간 없이 얼마나 빠르게 처리하는지가 중요하다. 학습은 시간당 얼마나 많은 데이터를 처리하는지가 핵심 요소다. 메모리가 연산한 값을 신속히 전달할 수 있는 PIM은 추론에 더 효과적인 셈이다.

PIM에서 한 단계 더 나아간 개념이 'CIM(Computing In Memory)'이다. CIM은 하나의 웨이퍼 안에 CPU와 메모리를 합친, 이른바 '궁극의 메모리'다. PIM이 하나의 패키지에 메모리와 프로세서를 합친 것이라면 CIM은 하나의 다이(Die) 안에 메모리와 프로세서가 들어간다. PIM이 칩 단위에서 연산 기능이 이뤄진다면 CIM은 셀 단위의 연산이 가능하다. PIM에 비해서도 시스템 성능이 비약적으로 개선될 수 있는 기술인 셈이다.

메모리 업체가 갈 길은

현재 메모리 업체들은 PIM이 기하급수적으로 규모가 증가하고 있는 초거대 AI 응용에서 에너지 효율을 높이는데 크게 기여할 것으로 보고 기술 개발에 한창이다. 이들은 PIM 기술을 다양한 제품에 적용하는 연구를 진행 중이다.

삼성전자는 2018년 세계 최초로 HBM에 PIM 기술을 적용한 HBM-PIM 제품을 선보인 바 있다. HBM-PIM은 HBM 내 뱅크에 인공지능 엔진(PCU)을 장착해 메모리 영역에서 연산 처리가 가능하다. 병렬처리가 극대화돼 성능이 혁신적으로 향상되고, 데이터 이동을 줄여 에너지 소비도 감소시킨다.

삼성전자에 따르면 HBM-PIM 탑재 시 PIM 기술을 적용하지 않은 GPU 가속기와 비교해 성능이 2배 이상 증가하고 에너지 소비는 50% 이상 감소한다. 기존 HBM 인터페이스를 그대로 지원하기 때문에 HBM을 이용하는 고객들이 하드웨어나 소프트웨어 변경 없이 시스템을 구축할 수 있다는 장점도 있다.

이밖에 삼성전자는 지난해부터 CXL(Compute Express Link) 인터페이스를 사용하는 CXL D램에서 PIM 아키텍처를 구성하는 연구도 함께 진행하고 있다. 또 D램 종류인 저전력더블데이터레이트(LPDDR)와 PIM의 조합도 준비 중이다. 올 초 CES 2024에서 LPDDR5X-PIM 제품을 처음으로 공개하기도 했다. 기존 LPDDR5X D램 대비 성능을 8배 높이고, 전력은 50% 절감했다. 삼성전자는 이를 온디바이스 AI용으로 상용화할 예정이다.

SK하이닉스는 자사의 PIM 반도체 제품명을 'AiM'으로 정하고, 지난 2022년 첫 제품으로 GDDR(그래픽더블데이터레이트)6에 PIM을 적용한 GDDR6-AiM을 선보였다. 초당 16기가비트(Gbps) 속도로 데이터를 처리하는 GDDR6 메모리에 연산 기능이 더해진 제품이다. 일반 D램 대신 이 제품을 프로세서와 함께 탑재하면 특정 연산의 속도가 최대 16배까지 빨라진다는 게 SK하이닉스 측의 설명이다.

또 지난해 9월에는 GDDR6-AiM 기반의 생성형 AI 가속기 카드인 AiMX 시제품을 공개하기도 했다. AiMX는 GDDR6-AiM 여러 개를 연결해 성능을 높인 가속기 카드다. GPU 대신 AI 연산에 활용할 수 있는데, GPU보다 속도는 빠르면서 더 적은 전력으로 데이터를 처리하는 게 특징이다. 실제 SK하이닉스 실험 결과, GDDR6-AiM 칩을 탑재한 AiMX 시스템은 GPU를 탑재한 시스템 대비 반응 속도는 10배 이상 빠르지만, 전력 소모는 5분의 1 수준으로 나타났다.

아직 먼 미래일까

업계에서는 향후 PIM 기술이 저전력으로 많은 데이터를 빠르게 처리하는 모든 영역에서 활용할 수 있을 것으로 기대하고 있다. 대표적으로 저전력 초거대 AI 모델을 활용한 챗봇과 각종 추천 서비스, 실시간 번역 및 음성 인식, 기후나 생명 등 과학 연구를 위한 슈퍼컴퓨팅, 저전력 온디바이스 AI 모바일 응용 등이다.

다만 PIM이 상용화하기까지는 상당한 시간이 걸릴 것으로 예상된다. 메모리에 연산 기능을 구현하는 것은 쉽지 않은 기술이다. 기존에 활용되던 컴퓨팅 시스템 자체가 바뀌어야 하는 탓이다. 데이터를 저장하기 위해 만들어진 장치에 연산 기능을 더하는 것이기 때문에 성능을 높이기도 쉽지 않다. 특히 AI용 반도체로 활용할 수 있을 정도로 성능을 끌어올리는 것은 더 오랜 시간이 필요할 터다.

기술 개발이 완료되더라도 메모리 업체 입장에서는 반도체 상용화 시점을 조율해야 하는 상황이기도 하다. 현재 메모리 업체들은 엔비디아, 인텔, AMD 등 CPU, GPU를 생산하는 업체에 HBM을 공급하며 협업하고 있는데, PIM 기술 도입으로 메모리가 프로세서 역할도 하게 되면 이들과 경쟁 관계에 놓일 수도 있기 때문이다.

가격 부담도 무시할 수 없다. 현재 AI 반도체 시장의 주류인 HBM 역시 높은 가격 탓에 기술 개발 이후 시장 개화가 다소 늦었다.

업계 관계자는 "PIM은 HBM으로도 감당 안 될 시장이 올 것이라고 보고, 먼 미래를 준비하는 차원의 기술"이라며 "좋은 솔루션이 맞지만 메모리와 프로세서의 영역이 겹칠 수 있기 때문에, 메모리 업체는 고객사와 영역 다툼을 해야 하는 상황이 올 수 있어 조심스러울 수 있다"고 밝혔다.