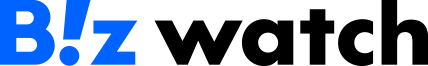

인공지능(AI) 챗봇 '이루다' 사태 및 불법 영상 제작 등에 쓰이는 '딥페이크'와 같이 AI가 사회적으로 피해를 주는 사례가 속출하면서 관련 윤리 규정을 제정하려는 움직임이 우리나라를 비롯해 미국과 중국 등 주요국에서 나타나고 있다는 보고서가 나와 관심을 모음.

정보통신기획평가원은 이 같은 내용을 다룬 'ICT Brief' 보고서를 발간. 보고서에 따르면 AI 기술이 빠르게 발전하면서 발생하는 사회적 부작용을 최소화할 필요성을 각국 정부가 절감하고 있음.

개인정보 유출 및 성희롱 등으로 물의를 빚은 스캐터랩의 인공지능(AI) 챗봇 이루다 등을 비롯해 AI가 사회적으로 문제를 주는 사례가 나타나고 있기 때문.

우리나라 정부는 이루다 사태 등 AI의 부정적 영향에 대응하기 위해 지난 13일 '신뢰할 수 있는 AI 실현 전략'을 발표.

구체적으로 오는 2025년까지 기술·제도·윤리 측면의 3대 전략과 10대 실행과제를 단계적으로 추진해 한국이 △책임 있는 AI 활용 세계 5위 △신뢰 있는 사회 세계 10위 △안전한 사이버국가 세계 3위에 오르는 것을 목표로 함.

이를 위해 정부는 민간 AI 구현을 정부가 체계적으로 지원하고 이용자가 이를 믿고 안전하게 사용할 수 있도록 제도를 보완할 계획.

이로써 사회 전반에 건강한 AI 윤리를 확산하는 것이 중점 방향.

한국뿐만 아니라 다른 주요국도 AI를 윤리적으로 활용할 수 있도록 하는 가이드라인 제정을 위한 움직임을 보임.

미국은 지난 2019년 국가 AI 연구개발 전략으로 '기술적으로 안전한 AI 개발'을 채택.

아울러 현지 IBM·마이크로소프트·구글 등 주요 기업은 AI 개발 원칙을 마련해 자율적으로 AI를 규제하는 '민간 자율 규제'를 중심으로 AI에 대한 신뢰성 확보 추진.

중국은 2019년 과학기술부 산하 국가 차세대 'AI관리특별위원회'가 8가지 항목의 차세대 AI 관리 원칙을 수립.

해당 원칙에는 AI 기술이 △화합과 우호 △공평과 공정 △포용과 공유 △프라이버시 존중 △제어 가능한 보안 △공동의 책임 △개방과 협력 △민첩한 관리 등이 필요하다는 내용이 담김.

유럽은 사용자에게 부정적 여향을 미칠 수 있는 고위험 AI를 중심으로 한 제도 정립을 진행 중.

그 일환으로 유럽연합(EU)은 지난달 4월 21일 새로운 AI 규제안을 공개.

세부적으로 △인간 생명과 생활에 위협을 미칠 수 있는 모든 AI의 포괄적 금지 △시민 기본권 침해 우려가 있는 AI 서비스 출시 전 사전 평가 등의 의무사항을 민간 기업이 지켜야 한다는 것이 핵심 내용.

프랑스는 2019년 기업, 시민 등 3000명이 참여한 공개 토론을 통해 '인간을 위한 AI' 구현에 필요한 권고사항을 도출.

영국은 현재 5대 AI 윤리 규범, 설명 가능한 AI 가이드라인 등을 마련한 상태.

미국·중국 등 주요국은 AI 시대를 맞아 안전한 AI 사회 구현을 목표로 윤리적 원칙, 신뢰·책임 등을 고려한 지침 마련 행보에 속도를 내고 있음.

보고서는 한국 정부도 국내 사회 및 경제에 적합한 실효성 있는 규칙 논의를 이어갈 것을 조언. 이를 통해 AI의 위험과 부정적 영향을 최소화하는데 만전을 기할 필요성을 언급하며 마무리.